RAG 논문 읽기 전 #1 : ORQA(Open-Retrieval Question Answering)

RAG 논문을 읽고 있는데 기본적으로 알아야되는 내용들이 많다. (https://arxiv.org/pdf/2005.11401)RAG는 검색(Retrieval)을 통해 얻은 외부 정보를 생성 모델(Generator)의 입력에 결합하여 답변을 만드는 기술

itstudentstudy.tistory.com

RAG 논문 읽기 전 #2

기존에 BERT와 GPT를 알고 있다면 BART는 BERT의 양방향 인코더 + GPT의 디코더이다.

BART는 Denoising Autoencoder로, 텍스트에 노이즈를 섞은 뒤 다시 원문으로 복구(Reconstruction)하는 과정을 통해 학습하는 Seq-to-Seq 구조의 모델이다.

BART 논문 (https://arxiv.org/pdf/1910.13461)

Abstract

1. 임의의 노이즈 함수로 텍스트를 손상시킨다.

2. 원본 텍스트를 복원하는 모델을 학습한다.

2. Model

BART는 Denoising Autoencoder로 손상된 문서를 원래의 문서로 복원하는 것을 목표로 학습하는 방식이다.

사전학습 과정에서는 원본 문서의 음수 로그 가능도(negative log likelihood)를 최적화 한다.

음수 로그 가능도(negative log likelihood) : loss function 종류. 로그 가능도($ \log P(y | x; \theta) $)를 최대화 하는 것은 음수 로그 가능도를 최소화하는 것.

2.1 Architecture

기본 BART 모델은 인코더와 디코더에 6개의 레이어를 사용하고, 대형 모델의 경우 각각 12개의 레이어를 사용한다.

Sequence-to-Sequence(Seq2seq) 모델로 구현

Seq2seq : 입력 시퀀스를 받아 출력 시퀀스를 생성하는 구조 (예 : 번역이나 요약)

📌 Bidirectional Encoder (양방향 인코더)

입력 텍스트를 양방향으로 모두 고려하여 문맥을 파악한다. BERT와 동일.

BERT는 인코더 마지막에 hidden state를 전체 시퀀스 요약 표현으로 사용하여 [cls] 토큰을 가지는데, BART는 [cls] 토큰을 생성하지 않는다. 3. Fine-tuning에서 디코더의 마지막 토큰의 Hidden State를 사용하여 분류 작업을 수행한다고 나온다.

BERT보다 약 10% 더 많은 파라미터를 가지는데, 디코더 레이어에 포함된 Encoder-Decoder Cross-attention 레이어로 인한 추가 파라미터들이다.

BERT uses an additional feed-forward network before word-prediction, which BART does not.

BERT는 단어 예측 전에 추가적인 피드-포워드 네트워크를 사용하지만, BART는 그렇지 않습니다.

📌 Auto-regressive Decoder (자기회귀 디코더)

자귀회귀 모델 : 미래의 값을 과거의 자신의 값들에 기반하여 예측하는 모델 (미래의 값은 마스킹 처리)

Masked Self-attention, Cross-attention, Feed-forward Network(피드포워드 신경망)으로 구성되어있음.

BART 모델에서는 GPU를 따라서 ReLU 활성화 함수가 아닌 GeLU(Gaussian Error Linear Unit)을 사용한다.

initialise parameters from N(0, 0.02) : 파라미터들은 평균이 0이고 표준편차가 0.02인 정규분포에서 무작위로 추출한 랜덤 값으로 설정한다.

-> BART는 BERT보다 약 10% 더 많은 파라미터를 가진다.

2.2 Pre-training BART

BART는 모든 유형의 손상을 적용한다.

- Token Masking : 무작위 토큰을 마스킹 [MASK] 처리

- Token Deletion : 무작위 토큰 삭제

어떤 위치에 삭제된 토큰이 있는지 모델은 맞춰야함. - Text Infilling

- 연속된 n개의 토큰 Masking : 여러 연속 토큰을 하나의 [MASK] 토큰으로 대체 (예 : ABC에서 BC를 마스킹 처리 -> A_)

시퀀스의 길이(문장의 길이)까지 추론해야해서 복잡도가 올라간다. - 0-length spans : [MASK] 토큰을 삽입한다. (예 : DE -> D_E)

- 해당 기법이 가장 일관되게 좋은 성능을 보였다.

- 연속된 n개의 토큰 Masking : 여러 연속 토큰을 하나의 [MASK] 토큰으로 대체 (예 : ABC에서 BC를 마스킹 처리 -> A_)

- Sentence Permutation : 문장을 나누고 무작위로 섞기

- Document Rotation : 문서 내 임의의 토큰을 선택하고, 해당 토큰이 문서의 시작이 되도록 회전시킨다.

(예 : ABCDE에서 C로 선택하면 -> CDEAB)

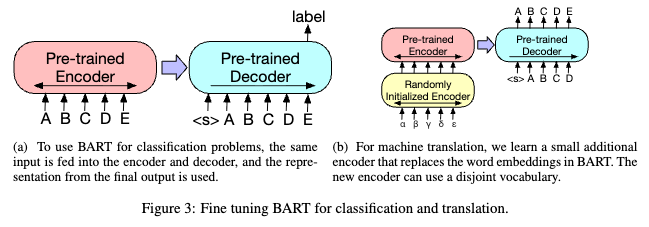

3. Fine-tuning BART

3.1. Sequence Classification Tasks (시퀀스 분류 작업)

BERT에게는 [cls] 토큰이 있는데 BART에게는 없다.

BART 모델의 디코더 마지막 최종 토큰으로 전체 시퀀스의 요약이 되는 토큰을 추가한다.

-> 입력 전체를 종합적으로 이해하는 성능이 강화된다.

For sequence classification tasks,

the same input is fed into the encoder and decoder,

and the final hidden state of the final decoder token is fed into new multi-class linear classifier

시퀀스 분류 작업의 경우,

동일한 입력이 인코더와 디코더에 공급되고,

마지막 디코더 토큰의 최종 은닉 상태가 새로운 다중 클래스 선형 분류기에 공급됩니다.

3.2. Token Classification Tasks (토큰 분류 작업)

토큰을 개별적으로 보고, 각 토큰에 대한 여러개의 결과를 가져온다.

각 토큰에 대한 디코더의 최상위 hidden state를 각 단어의 표현으로 사용한다.

-> 각 토큰에 대한 문맥적 이해도를 높여 개별 토큰 수준의 정확도를 높인다.

3.3. Sequence Generation Tasks (시퀀스 생성 작업)

auto-regressive 디코더를 사용하므로, 특정 목표에 맞게 시퀀스 생성에대한 fine-tuning 가능하다. (요약 or 답변생성 등,,,)

인코더 입력은 입력 시퀀스이고, 디코더에는 auto-regressive 출력을 생성한다.

3.4. Machine Translation (기계 번역)

기존 모델들은 인코더에는 개선된 성능을 보였지만, 디코더는 한계가 있었음.

-> BART 모델은 인코더와 디코더를 모두 사용하면서 생성에도 강함.

BART 모델은 외국어 단어를 영어로 de-noise할 수 있도록 훈련한다.

source encoder는 2단계로 학습하는데,,, 두 경우 모두 출력에서부터 Cross-entropy loss를 역전파한다.

Transfo

In the first step, we freeze most of BART parameters

and only update the ran- domly initialized source encoder, the BART positional embeddings,

and the self-attention input projection ma- trix of BART’s encoder first layer.

첫 번째 단계에서는 BART 파라미터의 대부분을 동결하고,

무작위로 초기화된 소스 인코더, BART 위치 임베딩,

그리고 BART 인코더 첫 번째 레이어의 셀프 어텐션 입력 프로젝션 행렬만 업데이트합니다.

In the second step, we train all model parameters for a small number of iterations.

두 번째 단계에서는 소수의 반복으로 모든 모델 파라미터를 훈련시킵니다.

-> 번역 성능을 높인다.

(a) 분류 문제 : 인코더-디코더에 동일한 입력이 들어가고, 디코더 마지막 단계에서 최종 repre-sentation(표현)을 결과로 사용한다.

(b) 기계 번역 : 원본 언어(α, β, γ, δ, ε) 입력으로 받아 타겟 언어(영어, A, B, C, D) 시퀀스를 생성한다.

'AI > [Paper]' 카테고리의 다른 글

| RAG 논문 읽기 전 #1 : ORQA(Open-Retrieval Question Answering) (0) | 2025.12.23 |

|---|---|

| [논문] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding (2) | 2025.12.17 |

| [논문] GPT-2 : Language Models are Unsupervised Multitask Learners (1) | 2025.12.05 |

| [논문] Attention Is All You Need - Transformer 모델 (0) | 2025.10.28 |